Hadoop技术已经无处不在。不管是好是坏,Hadoop已经成为大数据的代名词。短短几年间,Hadoop从一种边缘技术成为事实上的标准。看来,不仅现在Hadoop是企业大数据的标准,而且在未来,它的地位似乎一时难以动摇。

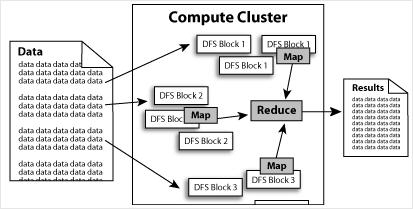

Hadoop的核心就是HDFS和MapReduce,而两者只是理论基础,不是具体可使用的高级应用,Hadoop旗下有很多经典子项目,比如HBase、Hive等,这些都是基于HDFS和MapReduce发展出来的。要想了解Hadoop,就必须知道HDFS和MapReduce是什么。

HDFS有着高容错性的特点,并且设计用来部署在低廉的(low-cost)硬件上。而且它提供高传输率(high throughput)来访问应用程序的数据,适合那些有着超大数据集(large data set)的应用程序。

HDFS放宽了(relax)POSIX的要求(requirements)这样可以流的形式访问(streaming access)文件系统中的数据。

⒈高可靠性。Hadoop按位存储和处理数据的能力值得人们信赖。

⒉高扩展性。Hadoop是在可用的计算机集簇间分配数据并完成计算任务的,这些集簇可以方便地扩展到数以千计的节点中。

⒊高效性。Hadoop能够在节点之间动态地移动数据,并保证各个节点的动态平衡,因此处理速度非常快。

⒋高容错性。Hadoop能够自动保存数据的多个副本,并且能够自动将失败的任务重新分配。

Hadoop带有用 Java 语言编写的框架,因此运行在 Linux 生产平台上是非常理想的。Hadoop 上的应用程序也可以使用其他语言编写,比如 C++。

1、存储文件的时候需要指定存储的路径,这个路径是HDFS的路径。而不是哪个节点的某个目录。比如./hadoop fs -put localfile hdfspat

一般操作的当前路径是/user/hadoop比如执行./hadoop fs -ls .实际上就相当于./hadoop fs -ls /user/hadoop

2、HDFS本身就是一个文件系统,在使用的时候其实不用关心具体的文件是存储在哪个节点上的。如果需要查询可以通过页面来查看,也可以通过API来实现查询。

粘粘世界 (World of Goo)中文版

70.7M / 中文08-11

粘粘世界 (World of Goo)中文版

70.7M / 中文08-11

孤单枪手之重临(AlienShooter:Revisited)v1.0 英文版

21.6M / 英文05-01

孤单枪手之重临(AlienShooter:Revisited)v1.0 英文版

21.6M / 英文05-01

GARNET CRADLE Sugary Sparkle

482.1M / 日文10-16

GARNET CRADLE Sugary Sparkle

482.1M / 日文10-16

nHancer v2.5.7游戏配置工具

1.5M / 中文10-09

nHancer v2.5.7游戏配置工具

1.5M / 中文10-09

宝库horad(HOARD)

382.8M / 英文11-27

宝库horad(HOARD)

382.8M / 英文11-27

dota6.72 test版本下载

7.5M / 英文04-21

dota6.72 test版本下载

7.5M / 英文04-21

星际争霸2DOTA0.9版(Defence of the Ancients0.9)测试

7.7M / 中文04-25

星际争霸2DOTA0.9版(Defence of the Ancients0.9)测试

7.7M / 中文04-25

星际争霸2DOTA1.0(Defence of the Ancients1.0)测试版

1.7M / 英文04-25

星际争霸2DOTA1.0(Defence of the Ancients1.0)测试版

1.7M / 英文04-25

星际争霸2DOTA帝国圣地风暴(SotIS)帝国圣地风暴

2.6M / 中文04-26

星际争霸2DOTA帝国圣地风暴(SotIS)帝国圣地风暴

2.6M / 中文04-26

Dota6.71b ai版6.71b ai地图

7.6M / 中文04-29

Dota6.71b ai版6.71b ai地图

7.6M / 中文04-29

妻中蜜3全cg存档

游戏工具 / 28KB

下载

1

妻中蜜3全cg存档

游戏工具 / 28KB

下载

1

csgo空格键连跳脚本绿色免费版

游戏工具 / 564KB

下载

2

csgo空格键连跳脚本绿色免费版

游戏工具 / 564KB

下载

2

DNF9周年第十套天空时装补丁

游戏工具 / 1.6M

下载

3

DNF9周年第十套天空时装补丁

游戏工具 / 1.6M

下载

3

易控王文档加密软件v2017官方版绿色免费版

文件处理 / 46M

下载

4

易控王文档加密软件v2017官方版绿色免费版

文件处理 / 46M

下载

4

dnf一键任务助手v0428最新免费版

游戏工具 / 863KB

下载

5

dnf一键任务助手v0428最新免费版

游戏工具 / 863KB

下载

5

3456wg多选皮肤v10.6官方版

游戏工具 / 2.2M

下载

6

3456wg多选皮肤v10.6官方版

游戏工具 / 2.2M

下载

6

爱普生R230打印机清零软件汉化版

办公学习 / 1.8M

下载

7

爱普生R230打印机清零软件汉化版

办公学习 / 1.8M

下载

7

adobe清理工具(AdobeCreativeCloudCleanerTool)V2017 绿色版

文件处理 / 5.9M

下载

8

adobe清理工具(AdobeCreativeCloudCleanerTool)V2017 绿色版

文件处理 / 5.9M

下载

8

视频、图片去水印大师HitPaw Watermark Removerv1.2.1 完美解锁版

文件处理 / 80.4M

下载

9

视频、图片去水印大师HitPaw Watermark Removerv1.2.1 完美解锁版

文件处理 / 80.4M

下载

9

GTKWave(WAV文件波形察看工具)v3.3.66 官方版

文件处理 / 4.4M

下载

10

GTKWave(WAV文件波形察看工具)v3.3.66 官方版

文件处理 / 4.4M

下载

10

140.5M / 09-05

立即下载

立即下载

76.4M / 03-25

立即下载

立即下载

55M / 06-05

立即下载

立即下载

88.7M / 04-13

立即下载

立即下载

900.9M / 03-02

立即下载

立即下载

96.2M / 07-06

立即下载

立即下载

311.2M / 07-06

立即下载

立即下载

335M / 07-06

立即下载

立即下载

200M / 07-06

立即下载

立即下载

413.8M / 07-06

立即下载

立即下载

480.3M / 01-03

立即下载

立即下载

768.9M / 08-19

立即下载

立即下载

165.4M / 09-05

立即下载

立即下载

131.8M / 04-13

立即下载

立即下载

195.6M / 03-03

立即下载

立即下载

45.6M / 09-08

立即下载

立即下载

665.2M / 07-06

立即下载

立即下载

2.84G / 07-06

立即下载

立即下载

93M / 07-06

立即下载

立即下载

338.3M / 07-06

立即下载

立即下载

959.8M / 12-24

立即下载

立即下载 312M / 07-30

立即下载

立即下载 1.38G / 07-26

立即下载

立即下载 109.8M / 06-03

立即下载

立即下载 142M / 01-08

立即下载

立即下载 1.2M / 11-23

立即下载

立即下载 548.8M / 04-13

立即下载

立即下载 1.6M / 04-13

立即下载

立即下载 1.48G / 03-18

立即下载

立即下载 646.6M / 03-03

立即下载

立即下载 401.9M / 01-06

立即下载

立即下载 1.89G / 12-19

立即下载

立即下载 110.5M / 09-05

立即下载

立即下载 33.4M / 09-05

立即下载

立即下载 60M / 04-29

立即下载

立即下载 254M / 04-25

立即下载

立即下载 659M / 04-23

立即下载

立即下载 253.4M / 12-08

立即下载

立即下载 253M / 12-08

立即下载

立即下载 1.19G / 11-16

立即下载

立即下载 118.2M / 01-06

立即下载

立即下载 488.3M / 06-04

立即下载

立即下载 369M / 09-22

立即下载

立即下载 181.5M / 09-22

立即下载

立即下载 201.2M / 09-05

立即下载

立即下载 248.9M / 12-08

立即下载

立即下载 248.9M / 12-08

立即下载

立即下载 100.6M / 03-06

立即下载

立即下载 148.9M / 03-06

立即下载

立即下载 1.12G / 07-06

立即下载

立即下载 126.7M / 02-04

立即下载

立即下载 1.76G / 09-22

立即下载

立即下载 1.92G / 04-17

立即下载

立即下载 201.5M / 04-13

立即下载

立即下载 7.31G / 07-01

立即下载

立即下载 94.3M / 07-06

立即下载

立即下载 2.48G / 07-06

立即下载

立即下载 7.63G / 07-06

立即下载

立即下载 1M / 07-06

立即下载

立即下载 778.1M / 07-06

立即下载

立即下载 1.40G / 12-19

立即下载

立即下载 72M / 07-06

立即下载

立即下载 548.7M / 07-06

立即下载

立即下载 1.00G / 07-06

立即下载

立即下载 9.13G / 07-06

立即下载

立即下载 126.2M / 07-06

立即下载

立即下载 72M / 07-06

立即下载

立即下载 105.1M / 07-06

立即下载

立即下载 132M / 07-06

立即下载

立即下载 132M / 07-06

立即下载

立即下载